本記事では、ChatGPTをモデルとしたファインチューニング(Fine-tuning)の概要や手法、具体的な応用例などについて初心者向けに詳しく解説していきます。

「ファインチューニング」は、主に深層学習やニューラルネットワークの文脈で使われる用語で、すでに訓練済みのモデルを特定のタスクやデータセットにさらに最適化するための追加の訓練を指します。

具体的には、大量のデータを用いて学習された汎用的なモデルを、ターゲットのタスクに特化させることで、高い精度を発揮することを狙います。

近年、自然言語処理や画像認識などの分野において、ファインチューニングは重要な技術となっています。特に、GPTシリーズなどの言語モデルによるファインチューニングは、文章生成や自動要約、感情分析などのタスクて優れた結果を出しています。

ファインチューニングとその利点

ファインチューニングとは、転移学習の一種であり、既に訓練されたニューラルネットワークモデルを新しい問題解決に適応させるための再学習の手法です。ニューラルネットワークの深層学習モデルは大量のパラメータを持ち、これらを最適化するためには大量のデータが必要となります。

データ不足の問題解決

充分な量のデータがある場合、深層学習モデルは高精度な結果を提供できます。しかし、データが不足している場合、その精度は著しく低下します。この問題を解決するためにファインチューニングが用いられます。事前学習済みのモデルを使用することで、学習過程を劇的に加速させることが可能となります。つまり小さなデータセットでも良好な性能を出せることが多いと考えられるのです。。

自然言語処理への応用

例えば、特定の自然言語処理タスクを解決したい場合、大規模な文章データセットで訓練された事前学習済みの言語モデルを利用することが一つのアプローチとなります。その言語モデルの一部を新しいタスクに合わせて再学習させることで、モデルは新しいタスクに対するパフォーマンスを向上させることが可能となります。この方法は、学習データが少ない場合や、新しい問題解決のための新しいモデルの開発に時間がかかる場合に特に有益とされています。

計算時間の削減

知識の転移: 事前訓練モデルは、大規模なデータセットで数日、数週間、またはそれ以上の時間をかけて訓練されることが多いです。これにより、モデルは多くの一般的な特徴やパターンを学習します。タスク固有のファインチューニングの際には、この既存の知識を利用するため、新しいタスクのための学習が高速になります。

初期値の利点: ニューラルネットワークの訓練は、初期の重みの値に敏感です。事前訓練モデルの重みは、多くのタスクで有用な特徴をキャッチするように最適化されているため、これを初期値として使用することで、収束速度が速くなります。

小さなデータセットの使用: ファインチューニングでは、通常、比較的小さなデータセットを使用します。これにより、エポックあたりの訓練時間が短縮されることが多いです。

性能向上

データの豊富さ: 事前訓練モデルは、多くの異なるタスクやデータ点からの情報を含んでいます。この広範な知識を基に、新しいタスクにも適応しやすくなります。例えば、言語モデルの場合、事前訓練により多岐にわたる文脈や文法を理解しているため、特定のタスクでの性能も向上します。

過学習の低減: 小さなデータセットを使用してモデルを一から訓練すると、過学習(overfitting)のリスクが高まります。過学習は、モデルが訓練データに特化しすぎて、新しいデータに対する性能が低下する現象です。事前訓練モデルを使用すると、このリスクが低減します。なぜなら、モデルはすでに多様なデータでの学習経験があるため、新しいタスクのデータのノイズや特異性に過度に影響されにくいからです。

多様な特徴の獲得: 事前訓練モデルは、大規模なデータセットで訓練されるため、多様な特徴を獲得しています。このため、新しいタスクにおいても、これらの特徴が役立つ場面が多いです。

ファインチューニングの具体的な手法

具体的には、ファインチューニングでは、新しいタスクに特化した部分をモデルの最後の層に追加し、その層の重みを再学習します。この方法により、新しいタスクに特化したモデルを効率的に作成することが可能となります。

転移学習とファインチューニングの違い

「転移学習」と「ファインチューニング」は深層学習の文脈で関連して使用されることが多く、しばしば混同されることもあります。しかし、これらは異なる概念であり、以下のように区別できます。

転移学習 (Transfer Learning)

転移学習は、あるタスク(ソースタスク)で学習された知識を別のタスク(ターゲットタスク)に適用する手法です。これは、ソースタスクのデータとターゲットタスクのデータが共通の特徴や構造を共有している場合に特に有効です。

- 特徴の再利用: 一般的には、ソースタスクで学習したモデルの下層(初期層)は、画像のエッジやテクスチャのような基本的な特徴を抽出する役割を持つことが多い。これらの一般的な特徴は、多くのタスクで再利用可能です。

- モデルの部分的な再利用: 転移学習では、モデルの一部の層のみをターゲットタスクに再利用することが一般的です。例えば、事前訓練された画像分類モデルの全結合層を取り除き、新しい層を追加して、新しいタスクでの学習を行う場合があります。

ファインチューニング (Fine-tuning)

ファインチューニングは、転移学習の一種として考えられることが多いです。事前訓練済みのモデルをベースにして、ターゲットタスクのデータでさらに学習を進めることを指します。

- モデル全体の再訓練: ファインチューニングでは、モデルの一部または全体の重みをターゲットタスクのデータで更新することが多い。

- 継続的な学習: モデルがソースタスクの知識を「忘れ」ないように、適切な学習率や正則化技術を適用しながら、新しいタスクのデータでの学習を進めます。

主な比較

- 転移学習は、あるタスクでの知識を別のタスクに適用する一般的な概念を指します。

- ファインチューニングは、転移学習の一手法として、事前訓練済みのモデルを新しいタスクのデータでさらに学習させることを指します。

言い換えれば、ファインチューニングは転移学習のサブセットと見なすことができます。

ChatGTPとファインチューニングの関係性

ファインチューニングは、既存の機械学習モデルを特定のタスクに適応させるプロセスを指します。これは、大量のデータに基づいて訓練された既存のモデルを利用し、その一部を新しいタスクに対応するように再訓練することを含みます。

ファインチューニングのプロセス

ファインチューニングの過程では、モデルの「凍結」されていた層(既に訓練されている部分)の一部を「アンフリーズ」(解凍)し、新たに追加された分類器層とともに再トレーニングを行います。この手法により、既存のモデルの性能を維持しつつ、新しいタスクに適応する能力を獲得します。ファインチューニングを行うためには、TensorFlowやKerasのような機械学習フレームワークが必要となります。

ChatGPTとの関係

例としてChatGPTというAIを考えてみましょう。ChatGPTは大量のテキストデータを用いて事前学習(プレトレーニング)を行っています。このプレトレーニングにより、ChatGPTは自然言語生成において高度な能力を持ちます。しかし、特定の言語や特定の専門領域においては、そのパフォーマンスが必ずしも最適であるとは限りません。

こうした場合、ファインチューニングを活用することで、ChatGPTを新たなタスクに対応させることが可能です。これにより、ChatGPTは更なる汎用性と、特定の問題領域に対する特化した性能を兼ね備えることができます。

ファインチューニングの成功のためのキー要素

ファインチューニングは、特定のタスクに対するデータセットを使用して、既存の事前学習済みの言語モデルを最適化し、特定のタスクに対応した性能を発揮するモデルを作り上げる手法です。この過程には、いくつか重要な注意点があります。

適切なデータセットの準備

ファインチューニングのプロセスでは、特定のタスクに適したデータセットを使用することが求められます。このデータセットは、ファインチューニングの目的に適した形式であることが重要です。不適切なデータセットを使用すると、モデルの性能が低下する可能性があります。

ハイパーパラメータの選択

ファインチューニングには、ハイパーパラメータの選択と調整が必要です。学習率、バッチサイズ、エポック数などのハイパーパラメータを適切に選択し、調整することで、モデルの最適な性能を引き出すことが可能です。

事前学習済みモデルの選択

ファインチューニングを行う際には、事前学習済みのモデルを選択する必要があります。モデルの選択では、そのモデルの初期性能や、タスクに対する適合性を考慮することが重要です。

過学習の防止

ファインチューニングの過程で、過学習を防止する方法としてデータ拡張やドロップアウト、正則化などの手法が用いられます。これらの手法を適切に選択することで、過学習を防ぎ、モデルの性能を向上させることが可能です。

モデルアーキテクチャの調整

ファインチューニングにおいては、モデルのアーキテクチャを調整することも必要な場合があります。入力の特徴量の数、中間層の数やサイズ、出力層の構成などを適宜調整することが求められます。

モデルの正則化の調整

モデルの過剰適合を防ぐために、正則化の適切な調整が必要です。正則化とは、モデルの複雑性を制限することで過学習を防ぐテクニックのことを指します。これにはL1正則化、L2正則化、ドロップアウトなどの手法が含まれます。これらの正則化手法を適切に選択し、調整することで、モデルの性能を最適化することが可能です。

以上の要素が、ファインチューニングを成功に導くための重要なポイントとなります。それぞれのタスクにより、これらの要素の適切な選択や調整が異なるため、各タスクに応じた最適な手法を選ぶことが必要です。これにより、特定のタスクに対する最適化された言語モデルを作り上げることが可能となります。

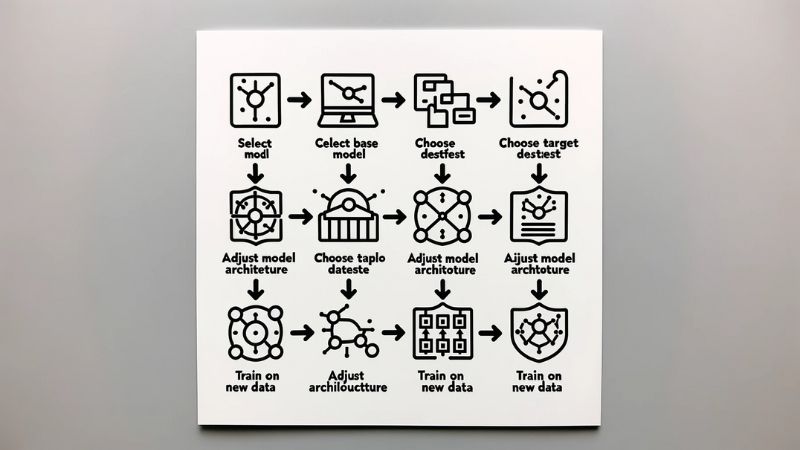

ファインチューニングの基本手順

ここで説明する手順は一般的なものであり、具体的な実装は使用するモデルやフレームワーク、タスクにより異なる場合があります。詳細な手順については、使用するモデルやフレームワークの公式ドキュメントを参照してください。

データセットの収集

ファインチューニングするためには、タスクに適した大量のデータを収集する必要があります。データは、入力と出力のペア、または入力に対するラベルなどの形式で提供されることがあります。

タスクに適したデータの収集は必要不可欠です。しかしながら、データがないまたは十分でない場合、データ拡張やシミュレーションを利用することでデータセットを増やすことが可能です。

データセットの前処理

収集したデータセットを、モデルが処理できる形式に変換する必要があります。これには、テキストデータのクリーニング、トークン化、およびベクトル化が含まれます。

また、事前学習済みのモデルに合わせたトークン化やエンコーディングが必要となります。特に、テキストのクリーニングはノイズを減らし、データの一貫性を保つために重要です。

モデルの構築

ファインチューニングするために、事前学習済みの重みを初期化して、タスクに合わせてモデルを構築する必要があります。タスクによっては、モデルのアーキテクチャを調整する必要がある場合があります。

モデルのアーキテクチャを調整する際には、新たなタスクの性質と既存モデルの特性を適切にマッチさせることが必要です。

モデルのトレーニング

前処理済みのデータセットを使用して、モデルをトレーニングする必要があります。トレーニングプロセスでは、損失関数を最小化するようにモデルを調整します(強化学習:Reinforcement Learningの場合)。

また、損失関数を最小化するようにモデルを調整することが一般的ですが、過学習を防ぐために、早期停止や正則化などの手法を適用することも重要です。

モデルの評価

トレーニングが完了したら、開発セットまたはテストセットを使用してモデルを評価する必要があります。評価には、精度、再現率、F1スコアなど、適切な指標を選択する必要があります。この評価指標はタスクによります。なお、評価セットはトレーニングセットとは独立であることが重要です。

ハイパーパラメータのチューニング

モデルのハイパーパラメータをチューニングして、モデルの性能をさらに向上させることができます。ハイパーパラメータには、学習率、バッチサイズ、エポック数、レイヤー数、ドロップアウト率などが含まれます。

また、ハイパーパラメータのチューニングは一般的にグリッドサーチ、ランダムサーチ、ベイズ最適化などの手法を用いて行われます。これにより、最適なパフォーマンスを得ることができます。

モデルのデプロイ

最終的に、ファインチューニングされたモデルをデプロイして、実際のタスクで使用する準備が整います。

モデルが適切に機能することを確認した後、実世界の問題に対して適用します。これは生産環境への移行を含み、それにはモデルのスケーリング、APIの設定、セキュリティ対策などが必要となります。

GT3のファインチューニングとは

OpenAIはGPT-3を含む自社のトランスフォーマー・ベースのモデルのファインチューニングを直接行うことは許可していません。しかし、ある特定のタスクにモデルを適応させるために、GPT-3 APIを利用するためのヒントやガイドラインを提供しています。

特にGPT-3では、”prompt engineering”と呼ばれる技術がよく使われます。これは、モデルに対する指示を工夫することで、特定のタスクに対するモデルのパフォーマンスを向上させる手法です。例えば、モデルに文章を生成させるとき、開始文やプロンプトを詳細に設定することで、目的の出力を得やすくなります。

また、GPT-3のAPIでは、temperatureとmax_tokensという2つの重要なパラメータを調整することができます。temperatureは出力のランダム性をコントロールします(低い値はより決定論的な出力を、高い値はよりランダムな出力を生成します)。max_tokensは生成されるテキストの長さを制御します。

しかし、APIを通じてのみアクセス可能なGPT-3の場合、モデル自体の内部パラメータ(例えば、ネットワークの重み)を直接調整することはできません。これはファインチューニングとは異なるアプローチで、プロンプトの工夫やパラメータの調整により特定のタスクに対するパフォーマンスを最適化します。

なお、OpenAIのポリシーや提供する機能は変更される可能性がありますので、常に最新の公式ドキュメンテーションを確認してください。

GPT-3のAPIを使用して特定のタスクを達成するためのガイドラインやベストプラクティスは、主にAPIドキュメンテーションに記載されています。ただし、具体的なヒントや技術的なガイドラインについては、特定のプロジェクトの要件や目標により異なる可能性があります。一般的な質問や問題については、OpenAIのサポートチームやコミュニティフォーラムも役立つリソースとなり得ます。

GPT-3のファインチューニング手順について以下に簡略的に説明します。ここでは、事前学習済みのGPT-3モデルを、新しいタスクに適用するためにファインチューニングする例を示します。

データの準備

まず、ファインチューニングに必要なデータを準備します。例えば、スパム検出のタスクを行う場合、スパムと非スパムのテキストデータを用意します。データをトレーニング、検証、テストセットに分割し、それぞれを適切に前処理しておきます。

モデルの準備

次に、事前学習済みのGPT-3モデルを準備します。これは、Hugging FaceのTransformersライブラリを使用して簡単に行うことができます。

※GPT-3の公式モデルの名前と、対応する正しいモデルクラスを指定します。以下のコードは例示的なもので、実際のコードとは異なる可能性があります。

python

from transformers import GPT3Model, GPT3Tokenizer

tokenizer = GPT3Tokenizer.from_pretrained('gpt-3')

model = GPT3Model.from_pretrained('gpt-3')

モデルのアーキテクチャの調整

次に、モデルのアーキテクチャを新しいタスクに適した形に調整します。これには、モデルの最後のレイヤーを変更して、出力を新しいタスクに対応するようにすることが含まれます。

※ここでも、実際にGPT-3の最後のレイヤーを調整する正確な手順は、特定のタスクやライブラリによります。以下のコードは例示的なもので、具体的な実装には適宜調整が必要です。

python

from transformers import GPT3ForSequenceClassification

model = GPT3ForSequenceClassification.from_pretrained('gpt-3', num_labels=2)

トレーニング

モデルをトレーニングします。これには、トレーニングデータをモデルに入力し、損失を最小化するように重みを調整することが含まれます。

python

from transformers import AdamW

from tensorflow.keras.callbacks import EarlyStopping

optimizer = AdamW(model.parameters(), lr=5e-5)

model.compile(optimizer=optimizer, loss=model.compute_loss)

early_stopping = EarlyStopping(patience=3)

model.fit(train_dataset, validation_data=val_dataset, epochs=10, callbacks=[early_stopping])

モデルの評価

最後に、テストセットでモデルを評価します。

python

model.evaluate(test_dataset)

以上が、GPT-3のファインチューニング手順の一例です。実際のタスクに合わせて、データやモデルのアーキテクチャを調整する必要があります。

ファインチューニング例2

ここでは、GPT-3モデルを使用して文章生成のタスクを行う場合のファインチューニング手順を説明します。

データの準備

まず、ファインチューニングに必要なデータを準備します。例えば、小説やニュース記事などのテキストデータを用意します。データをトレーニング、検証、テストセットに分割し、それぞれを適切に前処理しておきます。

モデルの準備

次に、事前学習済みのGPT-3モデルを準備します。

python

from transformers import GPT3Tokenizer, GPT3LMHeadModel

tokenizer = GPT3Tokenizer.from_pretrained('gpt-3')

model = GPT3LMHeadModel.from_pretrained('gpt-3')

モデルのアーキテクチャの調整

文章生成のタスクでは、一般的にモデルの最後のレイヤーは既にSoftmax関数を適用し、次に来る単語の確率分布を得ることが可能です。そのため、GPT-3の場合、モデルの最後のレイヤーを変更する必要は通常ありません。

転移学習によるトレーニング

モデルをトレーニングします。ここでは、事前学習済みのモデルをそのまま使うので、転移学習を行うことになります。トレーニングデータをモデルに入力し、損失を最小化するように重みを調整することが含まれます。

python

from transformers import AdamW

from tensorflow.keras.callbacks import EarlyStopping

optimizer = AdamW(model.parameters(), lr=5e-5)

model.compile(optimizer=optimizer, loss=model.compute_loss)

early_stopping = EarlyStopping(patience=3)

model.fit(train_dataset, validation_data=val_dataset, epochs=10, callbacks=[early_stopping])

モデルの評価

最後に、テストセットでモデルを評価します。生成された文章が適切なものであるかどうかを確認するために、人間が評価する必要があります。

python

generated_text = model.generate(input_ids, max_length=100, do_sample=True, num_beams=5, temperature=0.7)

以上が、GPT-3のファインチューニング手順の別の例です。こちらも実際のタスクに合わせて、データやモデルのアーキテクチャを調整する必要があります。

GT2を使用したファインチューニングの例

GPT-2は自然言語処理(NLP)タスクに適応力があるモデルで、その事前学習済みモデルをファインチューニングすることで、多くのNLPタスクに対応可能です。ここでは、GPT-2を使用した感情分析のタスクのファインチューニング例を説明します。

感情分析タスクでは、テキストの感情を予測します。これはポジティブ、ネガティブ、ニュートラルといった感情の分類を行うことを意味します。GPT-2は大量のテキストデータを用いて訓練されるため、感情分析のようなタスクに適用できます。

ファインチューニングの手順は次の通りです。

まず、GPT-2の事前学習済みモデルを読み込みます。

次に、感情分析タスクに必要な最終的な出力層を追加します。この出力層は感情のカテゴリー(例えば、ポジティブ、ネガティブ、ニュートラル)に対応するよう設計されます。

その後、ラベル付けされた感情分析データセットを用いてモデルを再訓練します。再訓練時には、事前学習済みのモデルの重みは固定され、新たに追加した出力層のみが訓練されます。訓練が進むにつれ、モデルは感情分析タスクに適応し、感情に関連する単語やフレーズを学習します。

最後に、訓練されたモデルをテストデータで評価し、感情分析タスクに対する精度を確認します。

以上の手順により、GPT-2の事前学習済みモデルを感情分析タスクに適したモデルにファインチューニングすることが可能です。同じ手順で、他のNLPタスクに対してもファインチューニングを適用することが可能です。

GPT-2を利用した感情分析プログラムのサンプルコード

ここでは、深層学習フレームワークであるPyTorchとGPT-2(GT2)を使ってテキストの感情分析を行うPythonプログラムのサンプルを紹介します。

最初に必要となるライブラリをインポートします:

python

import torch

import torch.nn as nn

from transformers import GPT2Tokenizer, GPT2Model, AdamW

次に、事前学習済みのGPT-2モデルとトークナイザーをロードします:

python

model = GPT2Model.from_pretrained('gpt2')

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

次に、感情分析タスクのための出力層を追加します。出力層は最終的な分類器として機能し、3つの感情クラス(ポジティブ、ネガティブ、ニュートラル)を出力します:

python

class GPT2SentimentClassifier(nn.Module):

def __init__(self):

super(GPT2SentimentClassifier, self).__init__()

self.gpt2 = GPT2Model.from_pretrained('gpt2')

self.classifier = nn.Linear(768, 3) # 3 classes: positive, negative, neutral

def forward(self, input_ids, attention_mask):

outputs = self.gpt2(input_ids=input_ids, attention_mask=attention_mask)

last_hidden_state = outputs[0][:, -1, :]

logits = self.classifier(last_hidden_state)

return logits

訓練データを用意するために、IMDbの感情分析データセットを読み込み、前処理を行います:

python

with open("imdb_reviews.txt", "r") as f:

reviews = f.readlines()

# Preprocessing

processed_reviews = []

for review in reviews:

review = review.strip()

review = review.lower()

processed_reviews.append(review)

次に、各レビューをトークナイズし、GPT-2モデルの入力形式に変換します:

python

input_ids = []

attention_masks = []

for review in processed_reviews:

encoded_dict = tokenizer.encode_plus(

review,

add_special_tokens=True,

max_length=512,

pad_to_max_length=True,

return_attention_mask=True,

return_tensors='pt'

)

input_ids.append(encoded_dict['input_ids'])

attention_masks.append(encoded_dict['attention_mask'])

input_ids = torch.cat(input_ids, dim=0)

attention_masks = torch.cat(attention_masks, dim=0)

そして、訓練データを使用して分類器を訓練します:

python

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model = GPT2SentimentClassifier().to(device)

optimizer = AdamW(model.parameters(), lr=2e-5)

input_ids = input_ids.to(device)

attention_masks = attention_masks.to(device)

labels =分類器を訓練するために、ラベルを設定し、データセットを作成します:

python

labels = [1 if i < 12500 else 0 if i < 25000 else 2 for i in range(0, len(input_ids))]

labels = torch.tensor(labels).to(device)

batch_size = 32

train_dataset = torch.utils.data.TensorDataset(input_ids, attention_masks, labels)

train_dataloader = torch.utils.data.DataLoader(train_dataset, batch_size=batch_size)

次に、エポック数、学習率などのハイパーパラメータを設定し、モデルの訓練を開始します:

python

num_epochs = 2

total_steps = len(train_dataloader) * num_epochs

scheduler = transformers.get_linear_schedule_with_warmup(

optimizer,

num_warmup_steps=0,

num_training_steps=total_steps

)

for epoch in range(num_epochs):

model.train()

total_loss = 0

for batch in train_dataloader:

batch_input_ids = batch[0]

batch_attention_masks = batch[1]

batch_labels = batch[2]

model.zero_grad()

outputs = model(batch_input_ids, batch_attention_masks)

loss = nn.CrossEntropyLoss()(outputs, batch_labels)

loss.backward()

total_loss += loss.item()

torch.nn.utils.clip_grad_norm_(model.parameters(), 1.0)

optimizer.step()

scheduler.step()

average_loss = total_loss / len(train_dataloader)

print("Epoch:", epoch+1, "Loss:", average_loss)

最後に、訓練済みのモデルをテストデータセットに適用し、正解率を計算します:

python

# Load and preprocess the test data

with open("imdb_reviews_test.txt", "r") as f:

test_reviews = f.readlines()

processed_test_reviews = []

for review in test_reviews:

review = review.strip()

review = review.lower()

processed_test_reviews.append(review)

test_input_ids = []

test_attention_masks = []

for review in processed_test_reviews:

encoded_dict = tokenizer.encode_plus(

review,

add_special_tokens=True,

max_length=512,

pad_to_max_length=True,

return_attention_mask=True,

return_tensors='pt'

)

test_input_ids.append(encoded_dict['input_ids'])

test_attention_masks.append(encoded_dict['attention_mask'])

test_input_ids = torch.cat(test_input_ids, dim=0)

test_attention_masks = torch.cat(test_attention_masks, dim=0)

test_input_ids = test_input_ids.to(device)

test_attention_masks = test_attention_masks.to(device)

# Predict on the test data

model.eval()

with torch.no_grad():

test_outputs = model(test_input_ids, test_attention_masks)

# Compute the loss here

以上がGPT-2を用いた感情分析プログラムの例です。これをベースに、独自のデータセットやタスクに適用できます。

まとめ

ファインチューニングは、大規模なデータセットを用いた事前学習モデルを特定のタスクに適応させることで、高い精度を発揮することができる有用な手法です。ChatGPTのような大規模な言語モデルも、ファインチューニングを行うことで、様々な自然言語処理のタスクにおいて高い性能を発揮することができます。

ただし、ファインチューニングにおいては、いくつかのパラメータを調整する必要があります。例えば、学習率やバッチサイズ、エポック数などがその一例です。これらのパラメータの最適値を見つけることが、高い精度を発揮するための重要なポイントとなります。

また、ファインチューニングを行う際には、過剰適合(オーバーフィッティング)に注意する必要があります。特定のタスクに適応しすぎて、汎用性が失われてしまうことを防ぐためには、正則化などの手法を取り入れることが重要です。

最終的に、ファインチューニングには試行錯誤が必要であり、パラメータの調整や過剰適合の防止などを行いながら、高い精度を発揮するモデルを構築することが求められます。